热门主题

百度安全登陆美国RSA大会 下一代MesaTEE提前亮相抢先看

2019-03-06 11:24:498767人阅读

网络安全的博弈从来都是场持久战,攻防之间的技术维度也在日益升级。而面对已然到来的AI时代,潜在的网络安全风险已不仅出现在数据层面,更凸显在其背后底层的技术逻辑。

由此,百度安全与英特尔联手打造的全球首个内存安全的可信计算架构MesaTEE应运而生。其将百度安全首创的高级内存安全技术模型Hybrid Memory Safety(HMS)和英特尔软件防护扩展Software Guard Extensions(Intel SGX)相结合,使内存安全可信的安全人工智能计算框架成为可能。

美国当地时间3月4日,在国际网络安全领域已有24年历史的RSA大会在旧金山开幕。作为重要的技术创新,百度安全与英特尔一起展示了MesaTEE在包括公有云、区块链在内的各类复杂场景中的对隐私数据和AI模型的强大保护能力。

在大会现场,百度安全还首次透露了即将发布的MesaTEE全新版本的相关信息——对云和边缘计算设备全面升级的AI算法保护支持,这也将是自2018年9月,百度首席安全科学家韦韬博士与英特尔副总裁Lorie Wigle共同宣布推出MesaTEE之后的一次重大技术升级。

韦韬博士与英特尔副总裁Lorie Wigle共同宣布推出MesaTEE

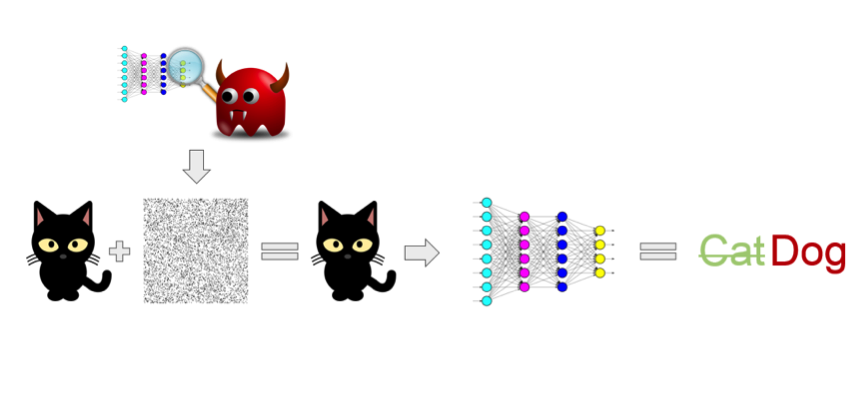

众所周知,AI系统中的机器学习容易受到对抗样本的攻击,对图像数据叠加部分人类难以通过感官辨识到的细微扰动,就可以“欺骗”机器学习模型做出错误的判断,未雨绸缪至关重要。

上图展示了在RSA大会上由百度安全展示的实验案例,通过一个普通的识别设备,AI系统正确的识别了一只猫的图像。但是,在其数据及AI模型被攻击者破解并生成一系列对抗性输入后,识别设备被“欺骗”,这只猫被AI系统错误地识别为一只狗。

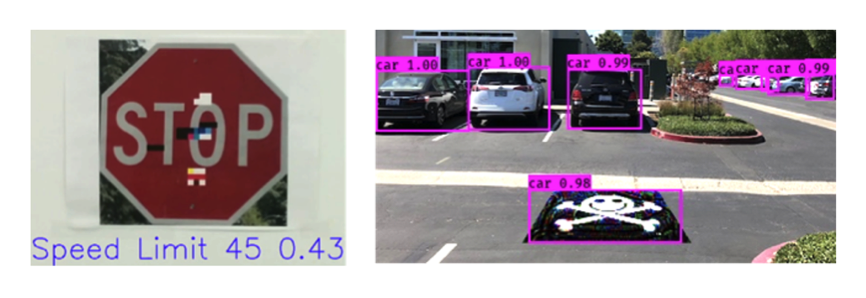

这样的情况还出现在自动驾驶领域,如下图所示,一方面,通过类似的数据篡改或在现实世界中实际的物理干扰,攻击者可让AI系统丧失对于道路标识和其他车辆正确的识别能力,造成严重的安全隐患;另一方面,一旦攻击者破译了其背后的AI模型,便可以绕过人脸识别系统解锁车辆或直接进行远程控制,实现对车辆的非法接管和对相关隐私信息的窃取。

要知道,当前很多AI系统在图像识别层面都存在着或多或少的技术漏洞,而目前这类方案已开始被应用于自动驾驶、医疗保健、金融认证、工业控制、大数据计算等场景之中,数据安全和隐私保护能力的缺位,将直接威胁你我的生命财产安全和社会的正常运转。提升AI识别系统的反欺骗能力,也是其在各类公共场景中大范围应用的安全前提之一。

事实上,MesaTEE所试图解决的正是这一在AI时代愈发迫切的问题。基于Intel SGX提供的硬件可信执行环境,MesaTEE实现了云上数据的完整性和保密性的芯片级安全保障,且不会导致性能和功能的显著降级。同时,通过允许用户对执行环境进行远程验证,确保远程执行环境符合预期,有效降低隐私数据的暴露风险。而借助HMS技术,MesaTEE还兼具了内存安全所带来的不可绕过性,使其能够抵御绝大多数的攻击——在上文所提及的“猫狗实验”中,在MesaTEE的环境下操作时,攻击者便未能获取相关信息并进行破解。

换句话说,MesaTEE为企业上云提供了更安全的端到端通道,并支持包括卷积神经网络在内的通用人工智能计算的理解和训练,性能与安全实现了统一。

尽管有着类似欧盟GDPR通用数据保护条例这样严格的法律规制,但在过去的一年中,全球范围内仍然发生了至少6500起、涉及超过50亿条含有隐私信息的数据泄露事件。保证底层技术方案的安全,是保证整个AI生态安全的重要基础之一。可以预见,以MesaTEE为代表的内存安全的可信计算架构将大大延展互联网信任的技术边界,基于此孵化出的下一代区块链基础设施、高速多方的安全计算,将广泛应用于大数据分析和机器学习中。

未来,百度和英特尔将进一步加强合作,推动可信安全计算应用落地。同时,也呼吁更广泛的社区生态合作,用技术助力AI时代发展,守护AI生态安全。